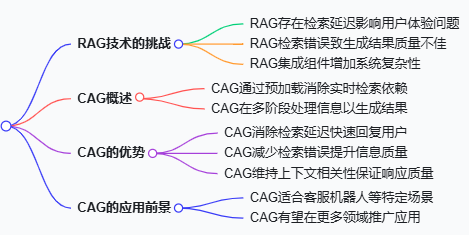

在知识密集型任务场景中,检索增强生成(RAG)技术一直发挥着重要作用。然而,RAG 技术也面临着一些挑战,而 “Cache-Augmented Generation” 即缓存增强生成(CAG),作为一种新方法应运而生,旨在应对这些局限。

RAG 技术的挑战

检索延迟

RAG 技术依赖实时检索文档,这在处理大型或复杂知识库时,耗时问题就会凸显。这种延迟不仅影响用户体验,也极大地限制了其应用场景。例如在一些对响应速度要求极高的实时交互场景中,RAG 的延迟问题就成为了阻碍其广泛应用的关键因素。

检索错误

文档选择或排序不准确的情况时有发生,这会导致信息不完整或不相关。特别是在处理复杂或模糊查询时,这种检索错误更为常见。这使得最终生成的结果质量大打折扣,无法满足用户对于精准信息的需求。

系统复杂性

集成检索和生成组件并非易事,需要仔细调优,还需要额外的基础设施以及持续的维护。这无疑增加了工作流程的复杂性和系统开销,提高了开发和运营的成本与难度。

CAG 概述

定义

缓存增强生成(CAG)通过预加载知识和预计算推理状态,消除了语言模型工作流程中对实时检索的依赖。这种方式为知识密集型任务提供了一种全新的解决思路。

工作原理

在模型训练或准备阶段,CAG 会预先收集和处理与应用程序相关的文档集合,并将其编码成键值(KV)缓存。同时,它会捕获大语言模型(LLM)的推理状态并存储起来。到了推理阶段,只需加载预计算的 KV 缓存和用户查询,就能生成相应的结果。例如在一些智能客服场景中,提前将常见问题及答案整理成文档集合进行处理和缓存,当用户提出问题时,快速加载缓存和查询信息,给出准确回复。

优势

CAG 具有显著优势,它消除了检索延迟,让用户能更快得到回复。同时,它还能最小化检索错误,大大提升了信息的准确性和完整性。同时,还能在确保模型整体处理所有相关上下文的情况下,保持高质量的响应,维持上下文相关性。

缓存增强生成(CAG)为知识密集型任务带来了新的解决方案,尤其适合那些对响应速度要求极高、对知识库大小有一定限制的场景 。例如在客服机器人、智能助手等领域,实时性是关键性能指标,CAG 通过预加载知识库,确保了快速响应,同时避免了传统 RAG 因实时检索带来的潜在误差 。随着技术的不断发展,CAG 有望在更多领域得到应用和推广,为知识密集型任务提供更高效、更优质的解决方案。