在当今大语言模型(LLM)飞速发展的时代,Model Context Protocol(模型上下文协议,简称 MCP)作为一项开创性的接口标准与开放协议,正引领着 LLM 应用走向新的高度。

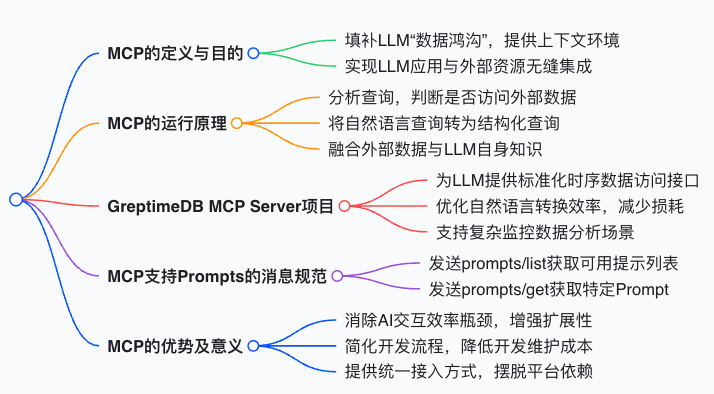

一、MCP 的定义与目的

传统的 LLM 存在明显的 “数据鸿沟”,只能访问训练截止日期前的数据,难以获取最新信息或特定领域的专业数据。MCP 的出现正是为了填补这一空白。它致力于为 AI 模型打造安全、可控的上下文环境,让模型能够安全地访问外部工具、数据源和计算资源,同时确保操作的可审计性与明确的权限边界。更为重要的是,MCP 实现了 LLM 应用程序与外部数据源和工具的无缝集成,成功地将 LLMs 与所需的上下文连接起来。

二、MCP 的运行原理

- 上下文识别:当接收到用户查询时,MCP 首先分析该查询,判断是否需要访问外部数据。这是整个流程的起点,精准的识别为后续操作奠定基础。

- 查询转换:将自然语言查询巧妙地转换为结构化查询,例如 SQL。这种转换使得查询能够被外部数据源理解和处理。

- 数据访问:通过预定义接口,MCP 可以高效地访问外部数据源,获取所需的数据。这一过程确保了数据的准确获取。

- 结果融合:将获取的数据与 LLM 自身的知识进行深度融合,从而生成综合全面的回答,为用户提供更丰富、准确的信息。

- 反馈优化:依据交互结果,不断对查询转换和数据访问策略进行优化,以提升整个系统的性能和准确性。

三、相关项目 ——GreptimeDB MCP Server

GreptimeDB MCP Server 是 GreptimeDB 团队推出的开源项目,聚焦于实现 Model Context Protocol。其核心目标涵盖多个方面:为 LLM 提供标准化的时序数据访问接口,使得 LLM 能够更便捷地获取时序数据;优化时序数据查询的自然语言转换效率,减少转换过程中的时间损耗;确保时序数据查询具备高性能和低延迟,满足用户对快速响应的需求;支持复杂的监控数据分析场景,为相关领域的应用提供强大支持。

四、协议消息(以支持 Prompts 为例)

在支持 Prompts 方面,MCP 有着清晰的协议消息规范。客户端可以通过发送 prompts/list 请求来获取可用的提示列表,并且该功能支持分页,方便用户根据需求获取信息。若客户端想要获取特定的 Prompt,则可以发送 prompts/get 请求,而且支持通过补全 API 自动补全参数,提升操作的便捷性。

五、MCP 的优势及意义

MCP 的出现带来了诸多积极影响。它消除了过去在使用 AI 交互工具时面临的效率瓶颈,赋予系统更高的灵活性与扩展性,这无疑是 AI 系统迈向真正自主智能代理的关键一步。对于开发者而言,MCP 极大地简化了开发流程,通过标准化接口,开发者能够轻松与不同的数据源和服务进行交互,有效降低了开发成本和维护负担。同时,MCP 提供了统一的接入方式,开发者可以自由选择不同的大语言模型提供商,摆脱了对单一平台的依赖。

Model Context Protocol 以其创新的理念和完善的架构,为大语言模型的发展注入了新的活力,有望在未来推动 AI 领域取得更为显著的进步。